Символи в цифровому світі: як комп’ютери зберігають літери та знаки

Кожен раз, коли ви набираєте повідомлення на клавіатурі, комп’ютер перетворює ці прості літери на складну послідовність нулів і одиниць, що ховаються в глибинах пам’яті. Цей процес, наче невидимий перекладач, визначає, скільки місця займе один-єдиний символ – від скромного байта до кількох, залежно від мови чи системи. Розуміння цього механізму розкриває, чому текстовий файл може несподівано розростися, а програми іноді спотикаються об екзотичні емодзі.

Уявіть старовинний телеграф, де кожен сигнал – це точка або тире, що несе повідомлення через океани. Сучасні комп’ютери роблять щось подібне, але з бітами: найменшими одиницями інформації, де 0 або 1 – це основа всього. Коли ми говоримо про об’єм пам’яті для одного символу, ми поринаємо в світ кодувань, де ASCII тримає фортецю для базових латинських літер, а Unicode розкриває двері для глобальних мов.

Ця тема не просто технічна дрібниця; вона впливає на все, від швидкості завантаження вебсторінок до зберігання даних у хмарі. Далі ми розберемо, як еволюціонували ці системи, і чому один символ може займати від 1 до 4 байтів, залежно від контексту. Готові? Почнемо з основ.

Основи вимірювання пам’яті: біти, байти та їх роль у кодуванні

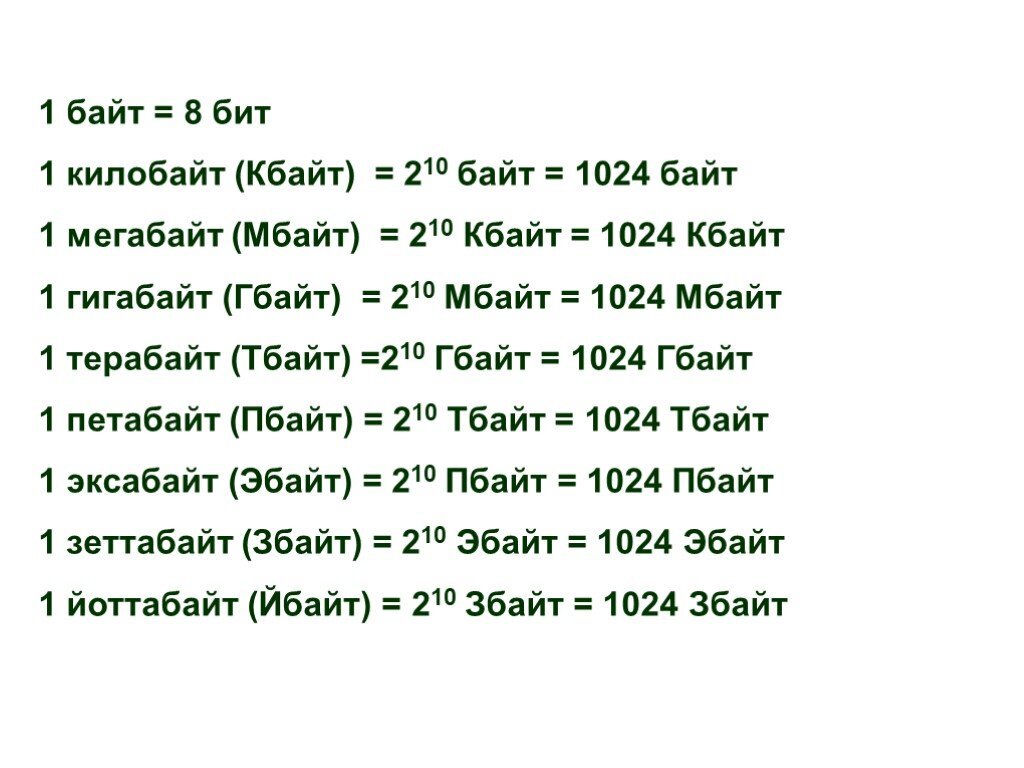

Біт – це фундаментальний будівельний блок цифрової інформації, наче атом у фізичному світі, що може бути лише у двох станах: увімкнено чи вимкнено. Вісім таких бітів утворюють байт, стандартну одиницю, яку комп’ютери використовують для зберігання даних. Саме байт визначає, скільки місця займає символ у пам’яті, бо кожен символ представляється унікальною комбінацією цих бітів.

Уявіть байт як маленьку коробку з вісьмома відділеннями, де кожне може містити 0 або 1. Ця коробка здатна представляти 256 різних комбінацій – від 00000000 до 11111111. Для простих символів, як англійські літери, цього вистачає з головою, але для складніших систем, як китайські ієрогліфи, потрібно більше коробок. Ось чому об’єм пам’яті для одного символу варіюється: в базових кодуваннях це 1 байт, а в розширених – до 4.

Цікаво, як це впливає на повсякденне життя. Наприклад, коли ви зберігаєте документ у текстовому редакторі, програма розраховує загальний розмір файлу саме на основі цих байтів. Якщо текст містить лише латинські символи, файл буде компактним, але додайте кирилицю чи емодзі – і розмір зросте. Це пояснює, чому деякі email-системи обмежують об’єм повідомлень, змушуючи нас оптимізувати контент.

Від біта до байта: проста математика

Один біт несе мінімальну інформацію, але для символу його замало – потрібна послідовність. Зазвичай, 1 байт = 8 бітів, і це стандарт у більшості систем. Однак, у деяких архітектурах, як старі мейнфрейми, байт міг бути 6 або 9 бітів, що додавало хаосу в ранні дні комп’ютеризації.

Щоб порахувати об’єм, візьміть символ ‘A’: в ASCII це 01000001, тобто рівно 1 байт. Але для ‘😊’ в UTF-8 знадобиться 4 байти, бо емодзі – це складний код, що охоплює більше комбінацій. Така варіативність робить програмування захопливим, але й підступним: помилка в розрахунку може призвести до переповнення буфера.

На практиці, розробники часто ігнорують ці нюанси, припускаючи фіксований розмір, що призводить до багів у міжнародних додатках. Я пам’ятаю, як одного разу проект зірвався через неправильне кодування кирилиці – файл роздувся вдвічі, і сервер не витримав навантаження.

Різні системи кодування: від ASCII до Unicode

ASCII, або American Standard Code for Information Interchange, з’явився у 1960-х як спосіб стандартизувати символи для комп’ютерів. Кожен символ тут займає точно 1 байт, охоплюючи 128 базових знаків: від ‘a’ до ‘z’, цифри та пунктуацію. Це було революційно для свого часу, наче універсальна мова для машин, що дозволила обмінюватися даними без плутанини.

Але світ не обмежується англійською. Розширені версії ASCII додали 128 символів для європейських мов, все ще в 1 байті. Проблема виникла з азійськими мовами, де тисячам символів не вистачало місця. Тут на сцену вийшов Unicode – глобальний стандарт, що підтримує понад мільйон символів, від єгипетських ієрогліфів до сучасних емодзі.

Unicode не фіксує розмір: він залежить від реалізації. UTF-8, найпоширеніший, використовує від 1 до 4 байтів на символ, оптимізуючи простір для поширених знаків. Наприклад, латинська ‘A’ – 1 байт, кирилична ‘А’ – 2 байти, а японський кандзі – до 3. Це робить UTF-8 ефективним для веб, де економія місця критична.

Детальний розбір UTF-8: змінний розмір для гнучкості

UTF-8 геніально балансує між компактністю та універсальністю. Перший байт вказує, скільки байтів йде за ним: якщо починається з 0, це 1 байт; з 110 – 2 байти тощо. Це дозволяє зберігати англійський текст так само ефективно, як ASCII, але розширюватися для інших мов.

Візьміть символ ‘€’ (євро): в UTF-8 це 3 байти (11100010 10000010 10101100). Чому не менше? Бо Unicode призначає йому код U+20AC, що вимагає більше бітів. У програмах на зразок Python функція len() рахує байти, а не символи, що може заплутати новачків – рядок з емодзі здаватиметься довшим, ніж є.

Перевага UTF-8 в тому, що він сумісний зі старими системами: ASCII-текст читається без змін. Але в базах даних це може збільшити об’єм: таблиця з мільйоном записів, де 10% символів – не-латинські, розростеться на 20-30% більше, ніж у чистому ASCII.

UTF-16 і UTF-32: фіксований розмір для швидкості

UTF-16 використовує 2 байти на більшість символів, що робить його популярним у Windows та Java. Базові символи, як латинські, займають 2 байти, а рідкісні – 4 (через сурогатні пари). Це забезпечує швидкий доступ, бо розмір передбачуваний, на відміну від UTF-8.

Наприклад, символ ‘A’ в UTF-16 – 00000000 01000001, тобто 2 байти. Для емодзі ‘👍’ – 4 байти. Це корисно в іграх, де швидкість рендерингу тексту критична, але витрачає більше пам’яті на простий текст. UTF-32 йде далі: завжди 4 байти на символ, ідеально для систем, де простір не проблема, як великі бази даних.

У мобільних додатках UTF-16 може бути кращим, бо процесори оптимізовані для 16-бітових операцій. Однак, для веб UTF-8 домінує, бо економить трафік.

Фактори, що впливають на об’єм пам’яті символу

Не тільки кодування визначає розмір: архітектура процесора, мова програмування та навіть операційна система грають роль. У 64-бітових системах покажчики на рядки можуть додавати overhead, роблячи ефективний об’єм більшим. Крім того, компресія, як gzip, може зменшити розмір файлу, але в оперативній пам’яті символи зберігаються в розгорнутому вигляді.

Уявіть рядок у Java: через UTF-16 він займає вдвічі більше, ніж у Python з UTF-8 для того ж тексту. Додайте метадані, як кодові сторінки в Windows (наприклад, CP1251 для кирилиці – 1 байт на символ), і картина ускладнюється. Для розробників це означає обережний вибір: економія пам’яті чи універсальність?

Ще один фактор – нормалізація: Unicode дозволяє комбіновані символи, як ‘é’ (e + акцент), що може займати більше байтів, ніж прекомпонований варіант. У базах даних, як MySQL, вибір кодування (utf8mb4 для повного Unicode) безпосередньо впливає на максимальний розмір рядків.

Практичні приклади та порівняння

Щоб побачити різницю наочно, розгляньмо таблицю, де порівнюємо об’єм пам’яті для одного символу в різних кодуваннях. Це допоможе зрозуміти, чому вибір системи важливий для проектів.

| Символ | ASCII (байти) | UTF-8 (байти) | UTF-16 (байти) | UTF-32 (байти) |

|---|---|---|---|---|

| ‘A’ | 1 | 1 | 2 | 4 |

| ‘А’ (кирилиця) | Н/Д (розширений) | 2 | 2 | 4 |

| ‘€’ | Н/Д | 3 | 2 | 4 |

| ‘😊’ | Н/Д | 4 | 4 | 4 |

| ‘你’ (китайський) | Н/Д | 3 | 2 | 4 |

З таблиці видно, як UTF-8 економить місце для латинських символів, але розростається для інших. У реальному кейсі, вебсайт з багатомовним контентом на UTF-8 заощадить гігабайти трафіку порівняно з UTF-32. Але в мобільних іграх UTF-16 прискорить рендеринг, бо фіксований розмір полегшує обчислення позицій.

Один з моїх улюблених прикладів – емодзі в соціальних мережах. У Twitter повідомлення з емодзі займають більше байтів, що впливає на ліміт символів: ‘Hello 😊’ – це 7 символів, але в UTF-8 близько 9 байтів. Це додає шарм, але й виклики для розробників.

Сучасні тенденції та виклики в кодуванні символів

У 2025 році, з ростом AI та глобалізації, кодування еволюціонує. Нові стандарти Unicode 15 додають символи для рідкісних мов, збільшуючи потенційний розмір. У хмарних сервісах, як AWS, оптимізація пам’яті для тексту стає ключовою: використання UTF-8 з компресією може знизити витрати на 30%.

Але виклики залишаються: в IoT-пристроях з обмеженою пам’яттю 1 байт на символ – розкіш, тому застосовують спеціальні кодування. У криптографії символи кодуються для безпеки, додаючи overhead. Я впевнений, що з появою квантових комп’ютерів ми побачимо нові парадигми, де об’єм пам’яті для символу стане ще гнучкішим.

Для програмістів порада: завжди перевіряйте кодування файлів. У Node.js, наприклад, неправильний буфер може спотворити текст. Це не просто теорія – це щоденна реальність, що робить цифровий світ таким динамічним.

Цікаві факти про об’єм пам’яті символів

- 🔤 У ранніх комп’ютерах, як IBM 701 з 1950-х, символи кодувалися в 6 бітах, дозволяючи лише 64 знаки – це було наче писати повідомлення з обмеженим словником, де бракувало половини алфавіту.

- 🌍 Unicode підтримує понад 149 000 символів, але лише 1% з них використовується щодня; решта – це історичні письмена, як клинопис, що займають 4 байти в UTF-8, ніби зберігаючи давнину в цифровому музеї.

- 🤖 Емодзі ‘😂’ займає 4 байти в UTF-8, бо поєднує кілька кодів, і в деяких системах це викликає баги – уявіть, як один смайлик ламає цілу базу даних!

- 🕰 ASCII спочатку мав 7 бітів, але додали 8-й для паритету – перевірки помилок, наче вбудований детектор брехні для даних.

Ці факти підкреслюють, наскільки кодування – це жива еволюція, повна сюрпризів. Уявіть, як один байт може змінити весь сенс повідомлення в коді. На цьому ми не зупиняємося: у світі даних завжди є місце для нових відкриттів, як-от оптимізація для VR, де символи інтегруються з 3D-елементами.